Kết quả nghiên cứu từ Đại học Rice tiết lộ rằng, khi các mô hình AI liên tục được huấn luyện bằng dữ liệu tổng hợp, chất lượng của chúng sẽ suy giảm theo thời gian, dẫn đến một hiện tượng gọi là “Rối loạn tự thực bào mô hình” (Model Autophagy Disorder – MAD).

Các mô hình trí tuệ nhân tạo (AI) tạo sinh, chẳng hạn như GPT-4 của OpenAI hay Stable Diffusion của Stability AI, nổi bật ở khả năng tạo ra văn bản, mã code, hình ảnh và video mới. Tuy nhiên, để huấn luyện các mô hình này, cần một lượng dữ liệu khổng lồ, và các nhà phát triển đang phải đối mặt với sự khan hiếm dữ liệu, thậm chí có nguy cơ cạn kiệt tài nguyên huấn luyện.

Do sự thiếu hụt này, việc sử dụng dữ liệu tổng hợp để huấn luyện các thế hệ mô hình AI tương lai có thể là một lựa chọn hấp dẫn đối với các công ty công nghệ lớn. Dữ liệu tổng hợp do AI tạo ra không chỉ rẻ hơn dữ liệu thực mà còn gần như không giới hạn về số lượng. Nó cũng giảm thiểu rủi ro về quyền riêng tư (ví dụ như trong trường hợp dữ liệu y tế), và trong một số trường hợp, dữ liệu tổng hợp thậm chí có thể cải thiện hiệu suất của AI.

Hệ quả của việc huấn luyện bằng dữ liệu tổng hợp

Tuy nhiên, nghiên cứu gần đây của nhóm Xử lý Tín hiệu Số tại Đại học Rice cho thấy rằng việc sử dụng dữ liệu tổng hợp liên tục có thể gây ra những tác động tiêu cực đáng kể đến các mô hình AI tạo sinh trong tương lai.

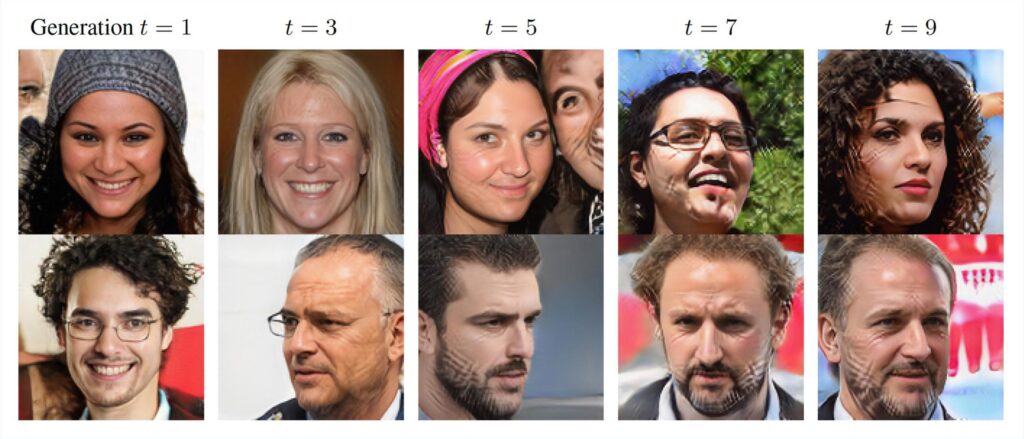

Tiến sĩ Richard Baraniuk, Giáo sư Kỹ thuật Điện và Máy tính tại Đại học Rice, giải thích: “Vấn đề nảy sinh khi việc huấn luyện bằng dữ liệu tổng hợp này lặp đi lặp lại, tạo thành một vòng lặp phản hồi tự tiêu thụ – mà chúng tôi gọi là vòng lặp tự thực bào hoặc vòng lặp ‘tự ăn chính mình’”. Khi mô hình được huấn luyện liên tục trên dữ liệu tổng hợp mà không có dữ liệu mới từ thế giới thực, chất lượng của mô hình sẽ giảm sút, và dần dần dẫn đến hiện tượng ‘sụp đổ mô hình’.”

Hiện tượng này tương tự như bệnh bò điên (mad cow disease), một bệnh thoái hóa thần kinh nghiêm trọng ở bò, có thể lây lan sang con người do ăn thịt bò bị nhiễm bệnh. Bệnh này bùng phát vào những năm 1980-1990 do thực hành cho bò ăn thức ăn được chế biến từ các phần còn lại của những con bò đã bị giết mổ, từ đó thuật ngữ “tự thực bào” (autophagy) ra đời, xuất phát từ tiếng Hy Lạp auto- nghĩa là “tự”, và phagy nghĩa là “ăn”.

Hậu quả và tương lai của AI tạo sinh

Nghiên cứu cho thấy, qua các thế hệ mô hình được huấn luyện liên tiếp trên dữ liệu tổng hợp mà không có đủ dữ liệu thực mới, các mô hình sẽ tạo ra các kết quả ngày càng bị biến dạng, thiếu chất lượng hoặc tính đa dạng. Nói cách khác, càng có nhiều dữ liệu thực mới, AI càng hoạt động tốt hơn.

Tiến sĩ Baraniuk và nhóm của ông đã nghiên cứu ba biến thể của các vòng lặp huấn luyện tự tiêu thụ để cung cấp một cái nhìn thực tế hơn về cách dữ liệu thực và tổng hợp được kết hợp trong các bộ dữ liệu huấn luyện:

- Vòng lặp hoàn toàn tổng hợp: Các thế hệ mô hình kế tiếp được huấn luyện trên một chế độ ăn dữ liệu hoàn toàn tổng hợp từ các đầu ra của các thế hệ trước.

- Vòng lặp tăng cường tổng hợp: Bộ dữ liệu huấn luyện cho mỗi thế hệ của mô hình bao gồm sự kết hợp giữa dữ liệu tổng hợp từ các thế hệ trước và một tập hợp cố định của dữ liệu huấn luyện thực.

- Vòng lặp dữ liệu mới: Mỗi thế hệ của mô hình được huấn luyện trên sự kết hợp giữa dữ liệu tổng hợp từ các thế hệ trước và một tập dữ liệu thực mới.

Trong những kịch bản này, việc thiếu hụt dữ liệu thực mới dẫn đến sự suy giảm nghiêm trọng về chất lượng và tính đa dạng của kết quả đầu ra. Nếu hiện tượng này tiếp tục, theo thời gian, các mô hình AI sẽ trở nên ngày càng thiếu chính xác và ít đa dạng, gây ra những hậu quả không mong muốn, thậm chí có thể ảnh hưởng đến chất lượng và tính đa dạng của toàn bộ dữ liệu trên Internet.

Để làm cho những mô phỏng này thực tế hơn, các nhà nghiên cứu đã thêm một tham số sai lệch lựa chọn (sampling bias) để mô phỏng xu hướng người dùng ưu tiên dữ liệu chất lượng hơn là đa dạng. Mặc dù điều này có thể duy trì chất lượng dữ liệu qua nhiều thế hệ mô hình, nhưng lại làm suy giảm tính đa dạng, dẫn đến nguy cơ các mô hình AI sẽ trở nên kém hiệu quả và đa dạng hơn theo thời gian.

Một kịch bản tồi tệ nhất có thể xảy ra là nếu không được kiểm soát, hiện tượng “MAD” có thể gây ô nhiễm toàn bộ dữ liệu trên Internet, làm suy giảm cả chất lượng lẫn tính đa dạng của dữ liệu.

Chú thích:

- Rối loạn tự thực bào mô hình (MAD): Hiện tượng mô hình AI tự tiêu thụ chất lượng của chính nó thông qua việc huấn luyện liên tục trên dữ liệu tổng hợp mà không có đủ dữ liệu thực mới.

- Dữ liệu tổng hợp: Dữ liệu do AI tạo ra, không phải từ các nguồn thực tế, thường được sử dụng để huấn luyện các mô hình AI.

- Tham số sai lệch lựa chọn: Xu hướng ưu tiên dữ liệu chất lượng cao hơn là đa dạng, dẫn đến sự suy giảm về tính đa dạng của mô hình AI.

Tham khảo: “Self-Consuming Generative Models Go MAD” by Sina Alemohammad, Josue Casco-Rodriguez, Lorenzo Luzi, Ahmed Imtiaz Humayun, Hossein Babaei, Daniel LeJeune, Ali Siahkoohi and Richard Baraniuk, 8 May 2024, International Conference on Learning Representations (ICLR), 2024. DOI: 10.1001/jamanetworkopen.2024.22749

продажа аккаунтов соцсетей биржа аккаунтов

безопасная сделка аккаунтов магазин аккаунтов

заработок на аккаунтах купить аккаунт

продажа аккаунтов соцсетей перепродажа аккаунтов

маркетплейс для реселлеров покупка аккаунтов

маркетплейс аккаунтов соцсетей магазин аккаунтов

безопасная сделка аккаунтов https://pokupka-akkauntov-online.ru

Account Selling Service Account Market

Profitable Account Sales Account Trading

Accounts marketplace Ready-Made Accounts for Sale

Gaming account marketplace Find Accounts for Sale

Buy Account Secure Account Sales

Account Trading Platform Find Accounts for Sale

Account trading platform Account marketplace

Website for Buying Accounts Account Acquisition

Secure Account Purchasing Platform Account Catalog

Verified Accounts for Sale Buy and Sell Accounts

account store accounts marketplace

find accounts for sale account buying platform

website for selling accounts profitable account sales

account trading platform account selling service